Les biais cognitifs en OSINT

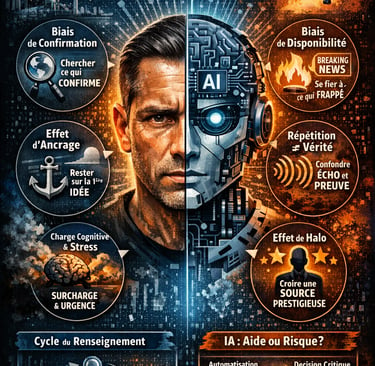

La qualité d’une production OSINT dépend moins de l’abondance des données ouvertes que de la capacité de l’analyste à raisonner de manière critique sous incertitude, souvent sous pression et en environnement potentiellement adversarial. Il distingue clairement heuristiques, biais cognitifs, erreurs et manipulation, afin d’adapter les contre-mesures à chaque type de vulnérabilité. L'article identifie ensuite les biais les plus opérationnels en OSINT (confirmation, disponibilité/saillance, récence, ancrage, « répétition ≠ corroboration », halo/autorité) et montre comment la charge cognitive, le stress et les dynamiques de groupe aggravent ces dérives, favorisant clôture prématurée et sur-pondération de signaux spectaculaires. La réponse proposée est une opérationnalisation plus rigoureuse du cycle du renseignement par la traçabilité (hypothesis log, plan de contradiction, grilles d’évaluation, comparaison structurée d’hypothèses, journal de décision, relecture critique). Enfin, l’article offre une lecture ambivalente de l’IA : utile pour le tri, l’extraction et la détection de patterns, mais risquée dès qu’elle induit surconfiance, ancrage sur la sortie machine et défaut de calibration, en particulier pour l’attribution et l’explication causale.

ARTICLES

Aurélien T

1/20/20268 min read

Perception, raisonnement et vérité : les biais cognitifs dans l’analyse OSINT à l’ère de l’intelligence artificielle

L’Open Source Intelligence (OSINT) occupe une place croissante dans les dispositifs de renseignement publics et privés. Toutefois, sa performance dépend moins de la quantité d’informations disponibles que de la capacité de l’analyste à raisonner de manière critique, sous contrainte d’incertitude et parfois en environnement adversarial. Cet article examine l’impact des biais cognitifs et des effets de contexte (charge cognitive, stress, saillance émotionnelle) sur les différentes étapes du traitement de l’information en source ouverte. En nous appuyant sur des références classiques de la psychologie du jugement et de l’analyse du renseignement, nous montrons que ces biais constituent une menace structurelle pour la fiabilité des productions OSINT. Nous plaidons pour une opérationnalisation plus rigoureuse du cycle du renseignement (livrables traçables, techniques d’analyse structurée, contrôle qualité). Enfin, nous proposons une lecture critique de l’intelligence artificielle : à la fois levier d’augmentation analytique et facteur de dérive (automation bias, ancrage sur la sortie machine, défaut de calibration).

1. Clarifier le terrain : heuristiques, biais, erreurs et influence

Une faiblesse fréquente des textes sur les biais tient à l’emploi d’un vocabulaire trop englobant. Pour une pratique OSINT/HUMINT robuste, il est utile de distinguer :

Heuristiques : raccourcis cognitifs souvent adaptatifs, mais susceptibles d’induire des erreurs en contexte complexe (cadre “heuristiques et biais”). (science.org)

Biais cognitifs : distorsions systématiques et reproductibles dans le jugement (ex. confirmation, ancrage). (pages.ucsd.edu)

Erreurs : fautes non systématiques (fatigue, distraction, défaut de procédure).

Influence/manipulation : action délibérée d’un acteur (coordination, astroturfing, deepfakes), qui exploite précisément ces vulnérabilités.

Cette clarification n’est pas “académique” : elle conditionne les contre-mesures. On ne traite pas une erreur de collecte comme on traite un biais de confirmation, ni une campagne d’amplification coordonnée comme un simple déficit de vérification.

2. OSINT : entre données ouvertes et risques “fermés” (le facteur humain)

L’OSINT est parfois présenté comme un renseignement “démocratisé” parce que fondé sur l’accès public. Pourtant, la valeur analytique réside dans la transformation de l’information en jugement. Les supports de formation OSINT rappellent explicitement le risque : mauvaise donnée + analyse biaisée → conclusions fausses → renseignement dégradé.

Cette chaîne d’échec n’exige pas des données frauduleuses : des données exactes peuvent produire une conclusion erronée si l’analyste fige prématurément une hypothèse, surpondère un signal saillant, ou confond répétition et corroboration.

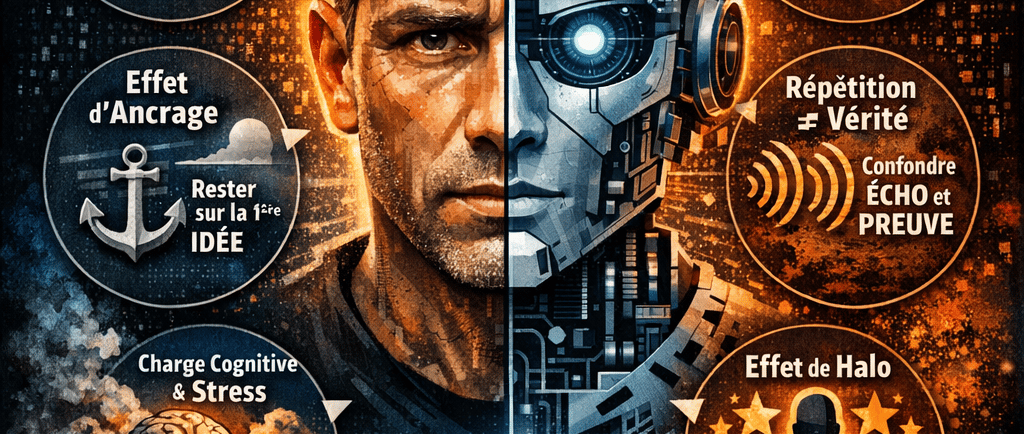

3. Les biais cognitifs les plus opérationnels en OSINT

Un biais cognitif est une déviation dans le traitement cognitif d'une information. Le terme biais fait référence à une déviation de la pensée logique et rationnelle par rapport à la réalité. Il existe des dizaines de biais cognitifs différents, qui peuvent tous conduire le sujet à accorder des importances différentes à des faits de même nature.

Pour l’OSINT, l’enjeu est de sélectionner ceux qui contaminent directement (i) la sélection des indices, (ii) leur pondération, (iii) la clôture de l’analyse.

3.1 Biais de confirmation (sélection orientée de la preuve)

Tendance à rechercher, interpréter et mémoriser l’information de façon conforme à l’hypothèse initiale. Ce biais est documenté comme “ubiquitaire” et particulièrement problématique lorsque l’incertitude est forte. (pages.ucsd.edu)

Indicateur pratique : présence d’un “dossier à charge” (preuves favorables) sans “dossier à décharge” (preuves réfutantes) explicitement recherché.

3.2 Disponibilité, saillance et récence (poids excessif du spectaculaire)

La disponibilité conduit à surestimer l’importance d’éléments récents, frappants ou émotionnels, indépendamment de leur représentativité. Elle est directement liée aux mécanismes classiques du jugement sous incertitude. (science.org)

Risque OSINT : un contenu viral, choquant ou massivement relayé devient “preuve centrale”, alors qu’il peut n’être qu’un artefact d’amplification.

3.3 Ancrage (verrouillage sur la première hypothèse plausible)

L’ancrage pousse à ajuster insuffisamment le jugement à partir d’une première information (ou d’une première interprétation). Il est décrit dans la littérature fondatrice sur heuristiques et biais. (science.org)

Risque OSINT : la première “narration” rencontrée structure l’investigation (queries, sources consultées, cadrage), produisant une boucle auto-validante.

3.4 Répétition ≠ corroboration (effet de vérité illusoire)

La répétition augmente la crédibilité perçue d’un énoncé, y compris pour des contenus discutables : c’est un mécanisme expérimental ancien et robuste (illusory truth). (ResearchGate)

Risque OSINT : confondre multiplication des occurrences (copier-coller, médias se citant, comptes coordonnés) et indépendance des sources.

3.5 Halo et autorité (crédibilité par transfert)

L’effet de halo décrit la contamination d’un jugement global par un trait positif (statut, expertise supposée), au détriment d’une évaluation dimension par dimension. (Massachusetts Institute of Technology)

Risque OSINT : surpondérer une source “prestigieuse” sans vérifier la chaîne primaire (origine, données brutes, méthode).

4. Effets de contexte souvent sous-estimés : charge cognitive et stress

Les biais ne s’expriment pas dans le vide : ils augmentent sous contraintes.

Charge cognitive : lorsqu’un environnement surcharge l’attention, l’analyste bascule plus facilement vers des traitements économes (heuristiques), ce qui dégrade la capacité de vérification fine. (ScienceDirect)

Stress : la littérature de synthèse montre que le stress modifie la prise de décision et les processus sous-jacents, ce qui est critique en cellule OSINT de crise (tempo, pression hiérarchique, incertitude). (PubMed)

Conséquence pratique : sans “points de rupture” procéduraux, l’urgence favorise la clôture prématurée, l’ancrage, et l’acceptation d’explications simples.

5. HUMINT et biais d’interaction : quand la collecte “fabrique” la preuve

Même en OSINT, la dimension HUMINT apparaît dès qu’il existe entretien, recueil de témoignages, échanges avec partenaires, ou validation par experts internes.

5.1 Contamination narrative et questions suggestives

La recherche sur la malléabilité de la mémoire montre que la formulation de questions peut altérer le souvenir rapporté (effets de reconstruction). (labs.la.utexas.edu)

Règle opérationnelle : séparer strictement récit brut (verbatim, chronologie) et interprétation ; privilégier des questions non suggestives et documenter les reformulations.

5.2 Preuve sociale, conformité et obéissance

Les dynamiques de groupe et d’autorité modifient la prise de position individuelle, y compris contre l’évidence perçue (conformité) ou sous injonction (obéissance). (nwkpsych.rutgers.edu)

Risque OSINT : alignement sur l’hypothèse dominante (ou celle du commanditaire) sans exploration suffisante des alternatives.

6. Le cycle du renseignement : du “cadre” à la traçabilité (anti-biais par conception)

L’apport majeur des travaux sur la psychologie de l’analyse du renseignement est de rappeler que l’esprit humain est structurellement limité face à l’ambiguïté, et qu’il faut des outils de compensation (auto-observation, structuration du problème, comparaison d’hypothèses). (CIA)

6.1 Recommandation centrale : exiger des livrables à chaque étape

Pour transformer le cycle en garde-fou, chaque étape doit produire un artefact vérifiable :

Orientation → Hypothesis log : hypothèses + prédictions observables + critères de réfutation.

Collecte → Plan de contradiction : liste de sources “à contre-sens” (adverses, indépendantes).

Traitement/évaluation → Grille fiabilité/crédibilité (ex. systèmes de codage utilisés en pratique policière/institutionnelle). (OSCE)

Analyse → ACH / comparaison structurée (expliciter ce qui infirme autant que ce qui confirme). (CIA)

Diffusion → Niveaux de confiance + incertitudes (langage standardisé).

Rétroaction → Decision journal / RETEX : raisons, hypothèses écartées, erreurs détectées.

Cette exigence de traçabilité réduit la dépendance à la mémoire, limite l’ancrage, et rend auditables les points de bascule.

7. Intelligence artificielle : aide analytique ou amplificateur de biais ?

L’IA introduit une ambiguïté majeure : elle peut augmenter la capacité de tri, mais aussi augmenter l’illusion de certitude.

7.1 Trois dérives à nommer explicitement

Automation misuse / surconfiance : sur-délégation et baisse de vigilance (faille de monitoring). (Massachusetts Institute of Technology)

Ancrage sur la sortie machine : la première réponse générée devient le cadrage de facto (effet d’ancrage transposé). (science.org)

Défaut de calibration : inadéquation entre confiance accordée et fiabilité réelle selon les tâches (extraction vs attribution).

7.2 Où l’IA est utile (et où elle est dangereuse)

Utile : dédoublonnage, détection de répétitions, clustering, extraction d’entités, repérage d’anomalies temporelles/linguistiques, cartographie de réseaux.

Dangereuse : attribution d’acteurs, intentions, causalité, inférences sociopolitiques sans preuves primaires, et toute conclusion “explicative” non falsifiable.

Enfin, les publications de référence sur les biais et risques socio-techniques en IA insistent sur la nécessité d’une gouvernance et d’une gestion explicite des biais au-delà du modèle lui-même (données, usage, contexte). (NIST Publications)

8. Kit minimal de contre-mesures (prêt à déployer)

Obligation d’alternatives : au moins deux hypothèses concurrentes, dès l’orientation (anti-confirmation).

Règle d’indépendance : distinguer répétition et corroboration (anti-illusory truth).

Artefacts de traçabilité : hypothesis log + decision journal (auditabilité).

Pair review structuré : un relecteur “sceptique” désigné (anti-conformité).

Humain dans la boucle, tâches bornées : IA cantonnée au tri/extraction, pas à l’attribution (anti-automation misuse).

Conclusion

La puissance de l’OSINT repose moins sur l’accès à l’information que sur la manière dont elle est pensée, évaluée et comparée. Les biais cognitifs ne sont ni des “défauts moraux” ni des maladresses : ce sont des propriétés ordinaires du jugement humain, aggravées par la surcharge, le stress et les dynamiques de groupe. La réponse professionnelle consiste à construire des garde-fous : cycle du renseignement opérationnalisé, analyse structurée, traçabilité, contrôle qualité, et intégration prudente de l’IA. La meilleure défense contre la manipulation n’est pas l’assurance, mais la combinaison de discipline méthodologique et d’humilité intellectuelle.

Bibliographie consolidée

Asch, S. E. (1951). Effects of group pressure upon the modification and distortion of judgments. In H. Guetzkow (Ed.), Groups, leadership and men. Carnegie Press. (nwkpsych.rutgers.edu)

Brashier, N. M., Eliseev, E. D., & Marsh, E. J. (2020). An initial accuracy focus prevents illusory truth. Cognition. (PubMed)

Brown, B. (2014). Cognitive Bias and Critical Thinking in Open Source Intelligence (OSINT) (slides). DeepSec.

Hasher, L., Goldstein, D., & Toppino, T. (1977). Frequency and the conference of referential validity. Journal of Verbal Learning and Verbal Behavior. (ResearchGate)

Heuer, R. J., Jr. (1999). Psychology of Intelligence Analysis. CIA, Center for the Study of Intelligence. (CIA)

Heuer, R. J., Jr., & Pherson, R. H. (2015). Structured Analytic Techniques for Intelligence Analysis (2nd ed.). CQ Press. (Google Books)

Loftus, E. F., & Palmer, J. C. (1974). Reconstruction of automobile destruction: An example of the interaction between language and memory. Journal of Verbal Learning and Verbal Behavior. (labs.la.utexas.edu)

Milgram, S. (1963). Behavioral study of obedience. Journal of Abnormal and Social Psychology, 67(4), 371–378. (demenzemedicinagenerale.net)

Nickerson, R. S. (1998). Confirmation Bias: A Ubiquitous Phenomenon in Many Guises. Review of General Psychology, 2(2), 175–220. (pages.ucsd.edu)

Parasuraman, R., & Riley, V. (1997). Humans and Automation: Use, Misuse, Disuse, Abuse. Human Factors. (Massachusetts Institute of Technology)

Schwartz, R., et al. (2022). Towards a Standard for Identifying and Managing Bias in Artificial Intelligence (NIST SP 1270). NIST. (NIST Publications)

Starcke, K., & Brand, M. (2012). Decision making under stress: A selective review. Neuroscience & Biobehavioral Reviews. (PubMed)

Sweller, J. (1988). Cognitive load during problem solving: Effects on learning. Cognitive Science, 12(2), 257–285. (ScienceDirect)

Tversky, A., & Kahneman, D. (1974). Judgment under Uncertainty: Heuristics and Biases. Science, 185(4157), 1124–1131. (science.org)

OSCE (2017). Guidebook on Intelligence-Led Policing. (mention des systèmes d’évaluation type 4x4/5x5x5). (OSCE)

SANS Institute (2024). Enhance your Cyber Threat Intelligence with the Admiralty System (présentation opérationnelle du codage). (SANS Institute)

Thorndike, E. L. (1920). A constant error in psychological ratings. (Massachusetts Institute of Technology)